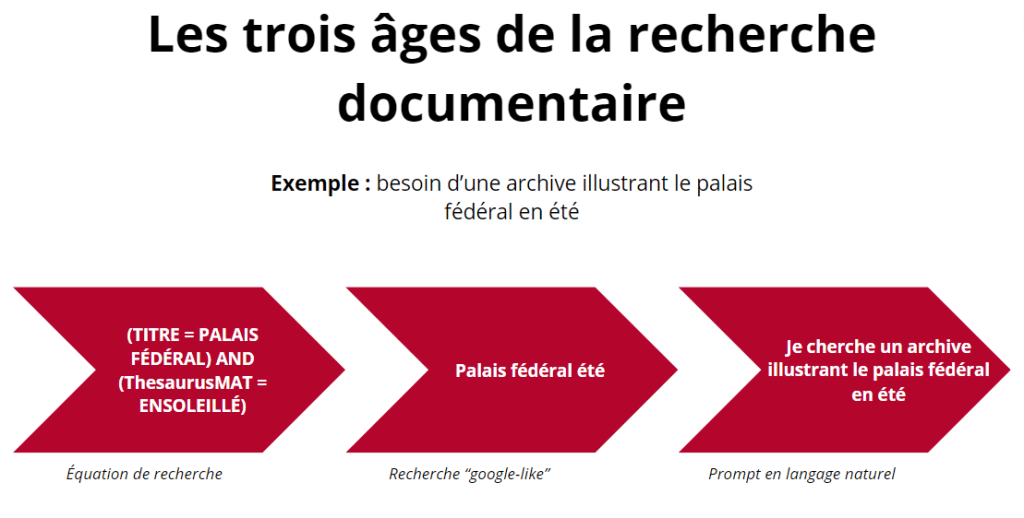

Précisons ici que nous ne nous concentrerons que sur un seul cas d’usage de l’intelligence artificielle ici, le RAG (retrieval augmented generation/génération augmentée de récupération) car il nous semble un tournant majeure pour la découvrabilité en contecte patrimonial (sujet des derniers articles de blog). Avant de se lancer, une explication technique est indispensable pour cerner les enjeux autour de cette technologie. Un RAG, donc, est un grand modèle de langue (le plus connu étant chat GPT) qui, pour répondre à une question de l’utilisateur (on parle de prompt), utilise des données fournies préalablement en tant que source (1). Cette approche combine donc les extraordinaires possibilités des modèles de langues dans la génération de réponses tout en corrigeant leur principal défaut : le manque d’indication des sources et le phénomène d’hallucination (2) ; en somme, leur manque de fiabilité. Pour les fonds patrimoniaux et leur découvrabilité, le potentiel d’une telle technologie est prometteur. Cela améliorerait grandement la recherchabilité en permettant aux utilisateurs de saisir, en langage naturel, leurs requêtes. De l’ère des équations de recherche, nous étions passés aux requêtes Google-like avec le RAG, nous passerions à l’ère du questionnement en langage naturel (3). Car le changement de paradigme principal de l’intelligence artificielle dite générative est bien celui-là : ce ne sont plus les humains qui font l’effort de communiquer dans une langue adaptée aux ordinateurs, mais le contraire, ce qui marquerait un « passage de la communication homme-machine à la communication machine-homme » (4). En termes de découvrabilité, cela signifierait qu’un chercheur/utilisateur du fonds de la RTS [Radio-télévision Suisse] (par exemple) pourrait directement demander dans une interface (souvent un chatbot dans le cas du RAG) « tous les documents concernant l’histoire de la Radiodiffusion en Suisse » dans le fonds de la RTS, ce qui évidemment — outre le fait d’être un immense gain de temps — représente une perspective de recherchabilité incroyable, car une telle requête actuellement ne donnerait que peu de résultats, ce champ n’existant pas dans le thésaurus.

Si la mise en place de RAG peut être vue comme une perspective passionnante pour les acteurs patrimoniaux, il n’en reste pas moins que cela pose de nombreux défis. Défi écologique (nous y consacrerons un billet de blog spécifique), défi éthique et juridique ensuite. La mise en place d’un RAG nécessite d’utiliser un grand modèle de langue (que les institutions patrimoniales ne développeront jamais en interne) provenant de sociétés privées, Google ou Open AI notamment, qui est ensuite adapté (« fine tuné ») avec les données internes pour être utilisé. Mais pour faire cela, il faut envoyer les données aux serveurs des entreprises (par le biais d’interfaces de programmation ou API), car il est très difficile d’entrainer localement ces modèles qui ont besoin d’une infrastructure importante et ne sont pas toujours en open source. Même si depuis peu Open AI et Google ont indiqué ne pas utiliser les données transférées pour entrainer leurs modèles (5), ces dernières sont tout de même stockées sur leurs infrastructures ce qui pose des questions de gouvernance de la donnée et de confidentialité en cas d’attaque.

Notons d’ailleurs que pour ces sociétés, les données extrêmement bien structurées des institutions patrimoniales sont véritablement du pain béni, en témoigne le récent partenariat qu’un consortium de trois sociétés spécialisées dans l’intelligence artificielle générative (Mistral AI, Giskard et Artefact) ont tissé avec la Bibliothèque nationale de France et l’Institut national de l’audiovisuel français (6). La BnF précise d’ailleurs : « le monde a redécouvert que toutes les bibliothèques nationales comme la BnF sont des grands réservoirs de données. Le nôtre est probablement le plus grand réservoir de données propres et qualifiées au monde. D’un seul coup, ça intéresse donc nos petits camarades qui travaillent sur l’intelligence artificielle parce qu’au-delà du logiciel, il faut de la donnée pour les entrainer ». Ces « grands réservoirs » deviendront sûrement un enjeu très important dans les années à venir puisque les besoins en données de l’intelligence artificielle générative sont de plus en plus importants. Les chercheurs évoquent d’ailleurs la date de 2026 comme celle où toutes les données publiques de l’Internet auront été aspirées par les modèles en formation (7). Même si beaucoup évoquent la possibilité de former ces modèles par des contenus générés par intelligence artificielle, il semble que cette piste ne donne pas de résultats très probants (pour l’instant, le domaine étant en évolution constante) (8).

Il y a, enfin, un défi de repérabilité, ces technologies ne font pas de miracles : si une partie du fonds n’a que peu de métadonnées, elle ne sera pas renvoyée. Prenons l’exemple de la RTS ici, on a noté dans notre état des fonds que le sport et les émissions pour enfants ont été peu archivés, et quand c’est le cas avec des métadonnées minimales : si un modèle RAG est mis en place, ces collections resteront invisibilisées, car mal documentées et en petit nombre. Les algorithmes, conçus en grande partie dans les pays occidentaux, commettent bien plus d’erreurs sur des groupes ethniques moins représentés dans leurs données d’entrainement que les groupes majoritaires. Parmis les risques de l’IA, l’exemple de Robert Williams est ici tristement éclairant. En 2020, cet homme afro-américain, a été arrêté et a passé trente heures en détention parce qu’un logiciel d’intelligence artificielle l’avait identifié à tord comme un voleur de montre, sans que cette “preuve” ait été remise en question à temps (9). Il y a ici un enjeu d’explicabilité algorithmique que nous traiterons aussi dans un prochain article de blog.

Au regard de ce qui a été écrit, il est essentiel, avant de se lancer dans la mise en production de RAG pour des collections patrimoniales, de réaliser un travail en profondeur sur les données et leur pondération. Dans le cas de la RTS, cela passerait par une transcription automatique de tous les programmes et la génération de résumés documentaires pour chacun (en utilisant comme données d’entrainement ceux déjà rédigés) ainsi que de mots-clés documentaires issus des thésaurus. Cela permettra un entrainement plus efficace (avec des coûts environnementaux et financiers réduits), car nécessitant moins d’itérations tout en réduisant les biais d’invisibilisation décrits, car tous les documents seront documentés avec la même précision.

Concluons avec ce qu’écrit Emmanuelle Bermès dans un article de blog : “Si ce genre de méthode doit révolutionner à terme la recherche documentaire et voir nos recherches par mots-clés disparaître au profit de prompts, comme la recherche par équation a disparu au profit de la recherche plein texte… On a intérêt à comprendre comment elles fonctionnent et à apprendre à les maitriser. Car le prompting, c’est comme la recherche documentaire : ça pourrait paraître simple à première vue, mais c’est une compétence de la littératie numérique qui ne s’invente pas (10).”

Notes

- Stéphane Pouyllau et LLAMA2 + Ollama, Quels usages du “Retrieval-augmented generation”

en SHS ?, HN Lab Log, Publisher : HN Lab, 17 mars 2024, url : https://hnlab.huma-num.fr/blog/

2024/03/17/RAG/ (visité le 19/08/2024). - Dans le domaine de l’intelligence artificielle, une hallucination ou une confabulation est une

réponse fausse ou trompeuse qui est présentée comme un fait certain ; par exemple, un chatbot qui génère

un chiffre d’affaires pour une entreprise sans avoir de données à ce sujet. – Wikipédia - E. Bermès, Le futur de la recherche documentaire : RAG time ! | Figoblog, Figoblog, 30 mars 2024,

url : https://figoblog.org/2024/03/30/le-futur-de-la-recherche-documentaire-rag-time/

(visité le 19/08/2024). - Hervé Pillaud, « Et si l’intelligence artificielle nous faisait changer de logique ? », Paysans &

société, 405–3 (2024), Place : Paris Publisher : Revue Paysans et Société, p. 25-33, doi : 10.3917/pes.

405.0025, p. 7. - Mathilde Rochefort, OpenAI n’utilise plus les données des clients de son API pour former ses

modèles, mai 2023, url : https://siecledigital.fr/2023/05/09/openai-api-formation-modeles/

(visité le 21/08/2024). - Martin Clavey, La BNF : un réservoir de données pour les IA, Next, 27 juin 2024, url : https:

//next.ink/142051/la-bnf-un-reservoir-de-donnees-pour-les-ia/ (visité le 19/08/2024). - sans auteur, Internet n’est pas assez développé pour former l’IA, mais une solution existe : les

fausses données, Forbes France, 29 juill. 2024, url : https://www.forbes.fr/technologie/internetnest-pas – assez – developpe – pour – former – l – ia – mais – une – solution – existe – les – fausses –

donnees/ (visité le 19/08/2024). - Entraîner une intelligence artificielle avec des données générées par IA conduit à l’absurde – Le

Temps, url : https://www.letemps.ch/sciences/entrainer-une-ia-avec-des-donnees-d-iaconduit-a – l – absurde ? srsltid = AfmBOopRmg4l1Q16bXgFanx2YVuh7h6o3CeuU05qkvmGvq9apQAlbtIS

(visité le 19/08/2024). - Etats-Unis : un Américain noir arrêté à tort à cause de la technologie de reconnaissance faciale,

url : https://www.lemonde.fr/international/article/2020/06/24/un-americain-noir-arretea-tort-a-cause-de-la-technologie-de-reconnaissance-faciale_6044073_3210.html (visité le 19/08/2024) - E. Bermès, Le futur de la recherche documentaire : RAG time ! | Figoblog…

Bibliographie

La bibliographie est commune à celle de l’article précédent.

Laisser un commentaire